La puissance de GPT-J

Depuis sa création par EleutherAI en juin 2021, GPT-J a attiré des tonnes d'utilisateurs NLP - data scientists ou développeurs - qui croient que ce puissant modèle NLP les aidera à porter leur application basée sur l'IA au niveau supérieur.

EleutherAI logo

GPT-J est puissant car il a été entraîné sur 6 milliards de paramètres. La conséquence est qu'il s'agit d'un modèle très polyvalent que vous pouvez utiliser pour presque n'importe quel cas d'utilisation NLP avancé (analyse de sentiment, classification de texte, chatbots, traduction, génération de code, génération de paraphrase, et bien plus).

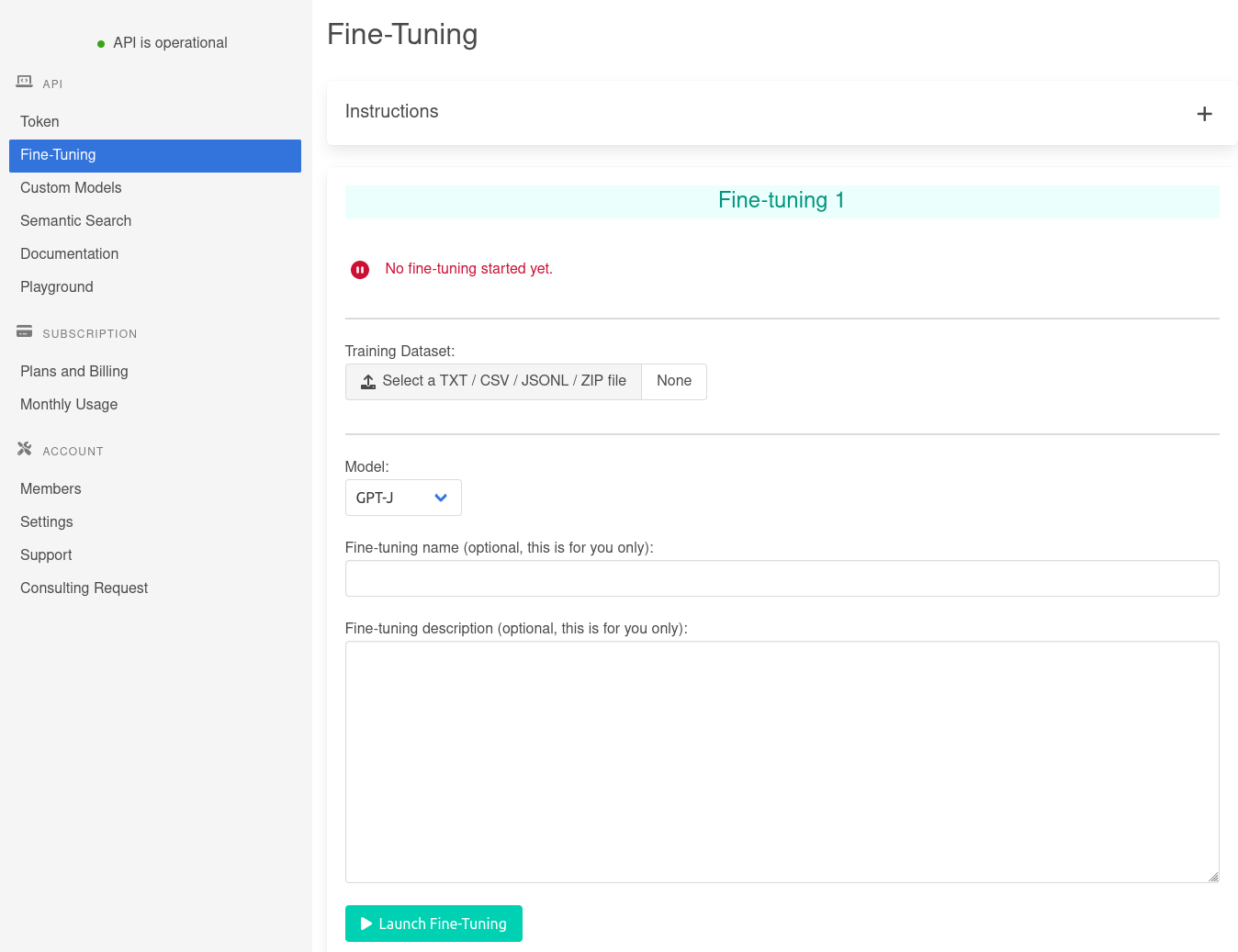

Il est possible d'adapte GPT-J à votre cas d'usage à la volée grâce à la technique du few-shot learning. Cependant, si le few-shot learning ne suffit pas, vous devrez opter pour une technique plus avancée: le fine-tuning.