Extraction d'entités à l'aide de l'apprentissage en quelques étapes

Nous allons maintenant effectuer l'extraction d'entités grâce à l'apprentissage en quelques coups.

Supposons que vous souhaitiez extraire des titres de postes à partir de sites Web. Donnez simplement quelques exemples d'extraction de titres de postes avant de formuler votre demande :

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:

Le résultat sera le suivant :

Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title: CTO

Comme vous l'avez remarqué, nous devons faire preuve d'intelligence dans la création de nos exemples. Il peut arriver qu'aucun titre de poste ne soit trouvé, c'est pourquoi nous avons créé un exemple renvoyant "aucun" (cela évite les faux positifs). Peut-être voulez-vous extraire plusieurs titres de poste en même temps ? Dans ce cas, il est important de créer des exemples renvoyant également plusieurs titres de poste (titres de poste séparés par des virgules, par exemple).

Vous obtiendrez des résultats encore meilleurs en ajoutant encore plus d'exemples. Et il est important que vos exemples soient aussi proches que possible de votre demande finale réelle. Par exemple, si vous savez que vous allez analyser des paragraphes entiers au lieu de simples phrases, il est préférable de créer des exemples avec des paragraphes également.

Si vous n'avez pas accès à un modèle TPG, vous pouvez simplement utiliser l'API NLP Cloud. Plusieurs clients sont disponibles (Python, Go, Node.js, Ruby, PHP...). Montrons ici un exemple utilisant GPT-J avec le client Python :

import nlpcloud

client = nlpcloud.Client("gpt-j", "your API token", gpu=True)

client.generation("""Extract job titles from the following sentences.

Sentence: John Doe has been working for Microsoft for 20 years as a Linux Engineer.

Job title: Linux Engineer

###

Sentence: John Doe has been working for Microsoft for 20 years and he loved it.

Job title: none

###

Sentence: Marc Simoncini | Director | Meetic

Job title: Director

###

Sentence: Franck Riboud was born on 7 November 1955 in Lyon. He is the son of Antoine Riboud, who transformed the former European glassmaker BSN Group into a leading player in the food industry. He is the CEO at Danone.

Job title: CEO

###

Sentence: Damien is the CTO of Platform.sh, he was previously the CTO of Commerce Guys, a leading ecommerce provider.

Job title:""",

top_p=0.1,

length_no_input=True,

remove_input=True,

end_sequence="###",

remove_end_sequence=True

)

Le résultat sera : CTO

Permettez-moi de vous donner une explication rapide sur les paramètres de génération de texte que nous venons d'utiliser.

Nous avons fixé une valeur p supérieure très basse car nous ne voulons pas que GPT-J crée des résultats trop originaux : nous voulons simplement qu'il s'en tienne à ce qu'il a vu dans votre demande.

"length_no_input" signifie que la valeur de la longueur maximale ne doit pas tenir compte du texte d'entrée.

"remove_input" signifie que le texte d'entrée doit être supprimé du résultat.

"end_sequence" signifie que lorsque le modèle rencontre ce caractère, il doit arrêter de générer du texte. Comme dans nos exemples en quelques clics, nous avons ajouté "###" à la fin de chaque réponse, le modèle générera automatiquement "###" après avoir généré la réponse et s'arrêtera là.

"remove_end_sequence" signifie que nous voulons supprimer "###" de la réponse.

Vous pouvez voir plus de détails dans la documentation de NLP Cloud : voir ici.

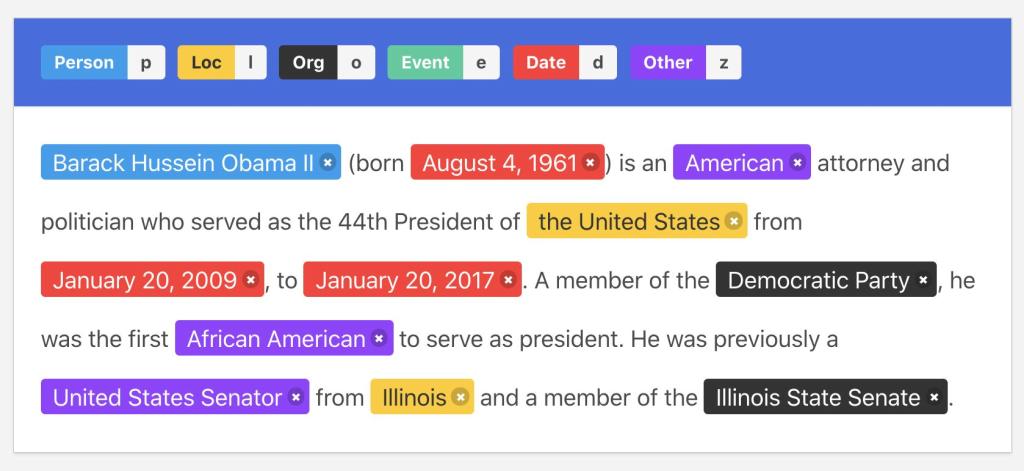

Illustration de l'annotation

Illustration de l'annotation